2016.10.14

周五。从长沙坐动车去上海。在虹桥火车站和 Cee,陈叔,思宇 汇合。去复旦。吃晚饭,Cee 在汉堡王用了一个非常有趣的 bug 来解决吃饭问题 😂。

晚上,HACKxFDU 开幕式。和 王鹏翰,冬瓜,鞠春利 见面,认识了 BlueCocoa 和其他人。

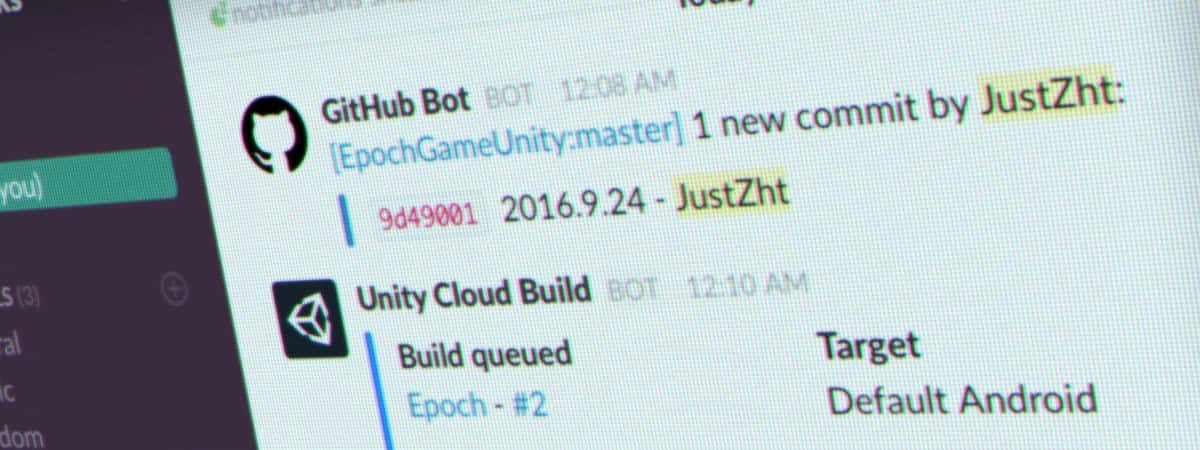

讨论了会这个 hackathon 要做什么,王鹏翰提起了一套方案,于是做 Delight。半夜,回宾馆,睡。

2016.10.15

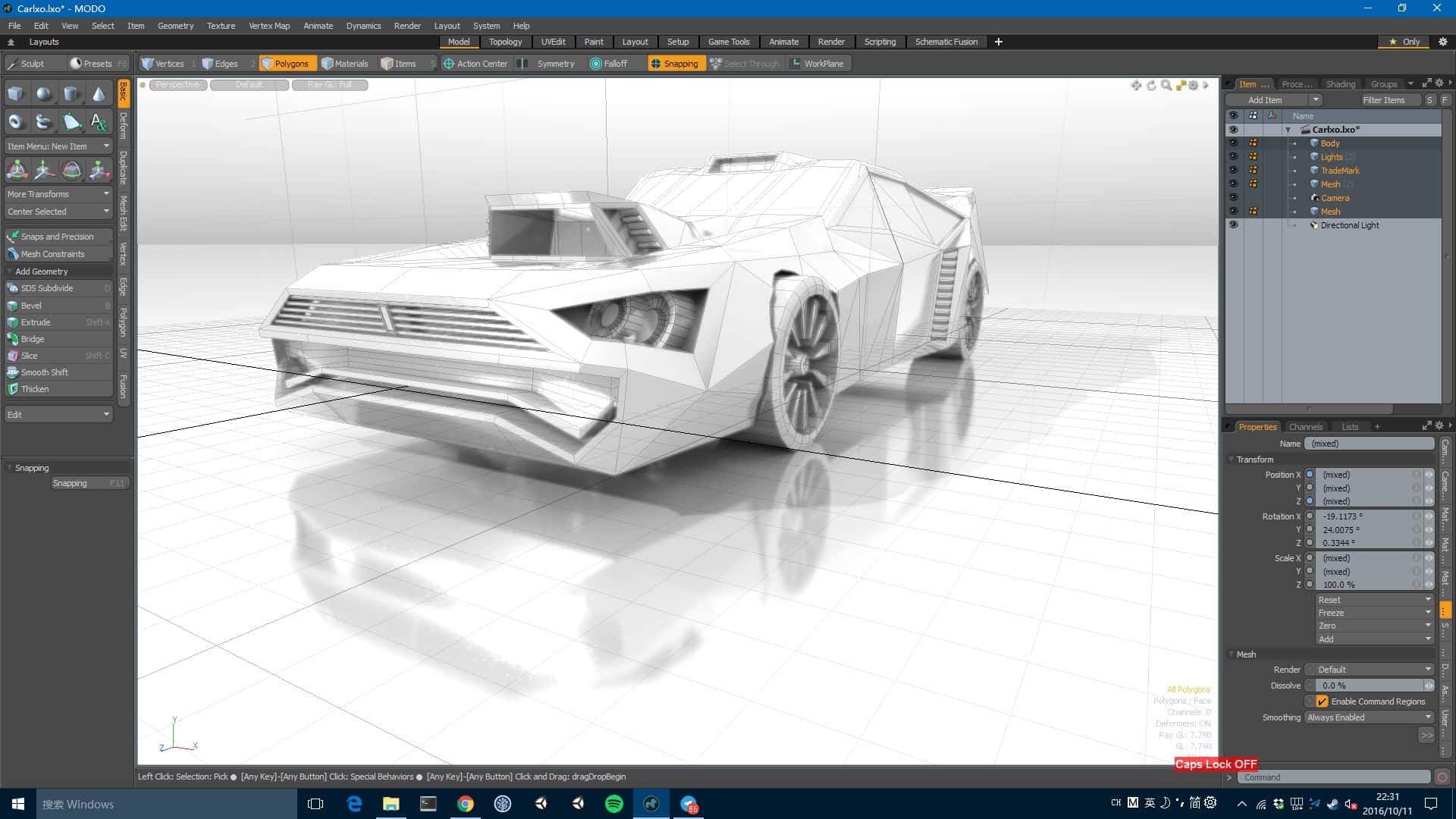

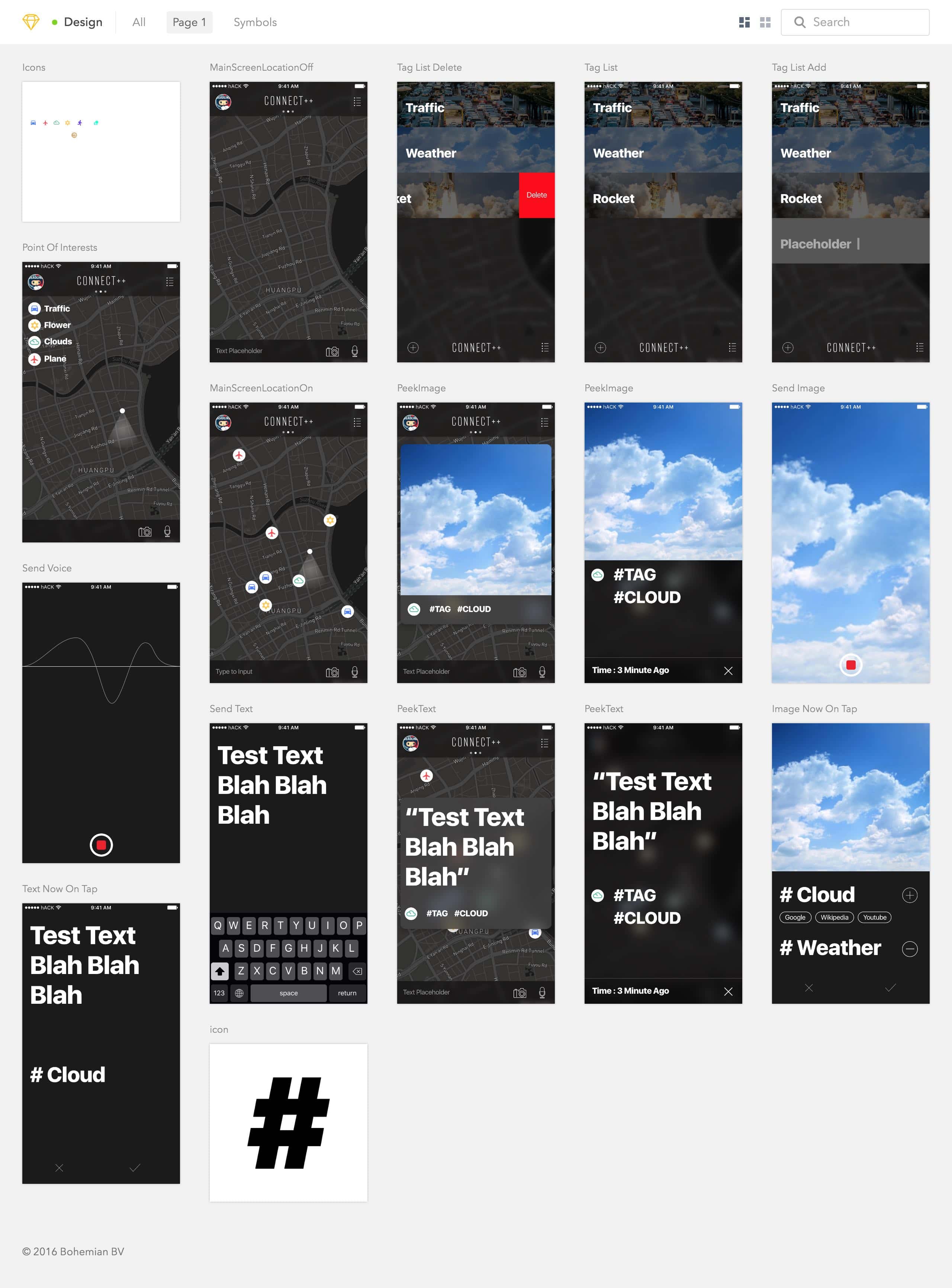

跑去云赛空间,参加 赛客·创享未来 开幕式。这次仍然是“不会骑自行车”的 烧碱 大人主持。讨论了下这个 hackathon 要做什么,结果是做 Connect++。我开始做 Connect++ 的 UI,思宇开始接微软 API,陈叔开始搭建 iOS Project,Cee 和王鹏翰一起在写 Delight 的网页,以及写 Connect++。

下午回到复旦赛场,完成了 Connect++ 的 UI。

夜间从复旦光华楼出,去云赛空间。王鹏翰在复旦会场继续写 Delight。我们在云赛空间开始写 Connect++。半夜陈叔和 Cee 骑着摩拜单车出去买东西吃。

2016.10.16

困。Connect++ 的基本功能在上午十点左右基本完成,于是我在会场打了两个小时的 PSV。中间大家调试了下微软的 API,但网络太差总是失败。Cee 和王鹏翰在给 Delight 打包成 Mac App。

下午陈叔,Cee,思宇在云赛空间开始展示 Demo,同时王鹏翰一人坚守复旦 Demo 位(...)。看完云赛所有队伍大家觉得有望卫冕(但是并没有,于是拿了三等奖(1W 块和一些外设)。知道名次后借口赶飞机立马退场,去复旦等王鹏翰,这个时候他已经进入前十,准备上台展示。

等待的时间里在复旦的食堂里面趴着睡了一觉。复旦的结果好像是没结果。去 吃饭,味道不错。大家一起吐槽两个 hackathon。

2016.10.17

今天。

早上八点半出门,去浦东机场。距离飞机起飞还有二十分钟的时候赶到机场,结果被告知不能打印登机牌了。

遂坐回虹桥,定动车票。下午我坐上了车,北京三人都已到站,而王鹏翰已经开始上课了(。

夜间到达长沙。

GET

- Octocat 一只 from Cee & Xhacker。心念念很久的玩偶,还是八月份在北京的时候说的,后来九月回学校就一直没有拿到。

- 这算是我第一次在 hackathon 里作为设计师完成项目,个人认为做的还不错(当然是以快速 hackathon 的水准来看):

- 团队两天来回参加并行 hackathon 做两个项目的感觉。估计国内也没几个像 hACKbUSTER 这么丧心病狂地干了吧。但以后再也不能这么干了,爆肝。

吐槽

1.复旦的管理工作太乱了,中间遇到了去 IBM 问一下 API 回来位子就被占也无人解决的事情。此外,复旦没大奖啊,就是因为这个所以我们才动了一下子去俩 hackathon 的念头。

2.云赛的评委里感觉有并不是很懂技术的。团队里面只有 PPT 没有真机演示的太多,静态页面拿来当 Demo 的也太多。

3.云赛的奖品外设很尴尬 —— 华硕的游戏外设,价格和 hhkb 差不多,但在程序员眼里价值和流通度就不一定了。

关于两个 hackathon 项目

Connect++ 是一个 iOS app,可以在这个软件内拍照,图片会自动通过微软的 CV 图像识别处理,然后自动标记 tag,并有类似于 Google Now On Tap 的内容推荐。可以在地图界面 Peek&Pop 不同 tag 类目的兴趣点。

Delight 是一个 Atom Shell App,用于教师和学生或幼年儿童的互动教学。代码可以同步显示,同步编辑,并且有自带的 console,test case 和文档教学面板。

All Code and Design files Hosted On hACKbUSTER

2016.10.18 Update : Cee 写了一篇 文章,比我写的更翔实。